AI가 거짓말을 한다고요? 인공지능 '할루시네이션'의 모든 것!

📌인공지능 할루시네이션(AI Hallucination)이란?

인공지능이 만들어내는 정보가 모두 진실일까요?

정답처럼 보여도 실상은 "없는 사실을 마치 있는 것처럼" 말하는 경우가 많습니다.

이런 현상을 우리는 **"인공지능 할루시네이션(AI Hallucination)"**이라 부릅니다.

📌 AI 환각이란?

AI 할루시네이션은 인간의 환각처럼 눈앞에 없는 것이 보이는 것이 아니라,

AI가 실제로 존재하지 않는 정보나 잘못된 사실을 스스로 만들어내는 현상을 말합니다.

📌 정의:

AI가 근거 없는 내용을 마치 사실인 것처럼 자신 있게 말하는 오류 현상

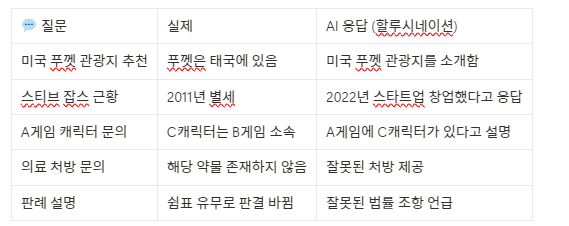

📌 대표적인 할루시네이션 예시

AI가 만들어낸 잘못된 응답은 겉보기엔 자연스럽고 신뢰감 있게 보이지만, 그 내용을 뜯어보면 전혀 사실이 아닌 경우가 많습니다. 대표적인 예시 몇 가지를 살펴보겠습니다.

첫 번째로 자주 발생하는 유형은 지리 정보에 관한 오류입니다. 예를 들어, 사용자가 "미국 푸껫에서 가볼 만한 관광지를 추천해줘"라고 질문했을 때, AI는 푸껫이 미국이 아닌 태국의 관광지임에도 불구하고, 이를 정정하지 못하고 미국의 장소로 오해한 채 정보를 제공하는 경우가 있습니다.

두 번째는 유명인 관련 오보입니다. 예컨대 “스티브 잡스가 최근 창업한 회사에 대해 알려줘”라고 하면, AI는 잡스가 이미 2011년에 세상을 떠났음에도 불구하고, "2022년에 새로운 회사를 세웠다"고 사실이 아닌 내용을 자신 있게 말할 수 있습니다.

또 하나의 흔한 할루시네이션은 게임 캐릭터 정보 왜곡입니다. A게임에 등장하지 않는 C라는 캐릭터가 B게임에만 등장하는데도, “A게임에 나오는 C캐릭터를 소개해줘”라고 물으면 AI는 C캐릭터가 A게임에 등장한다고 설명하며, 마치 진짜인 것처럼 이야기합니다. 특히 마이너한 콘텐츠일수록 이런 오답률은 더욱 높아집니다.

의료 분야에서도 위험한 할루시네이션이 발생할 수 있습니다. 사용자가 증상을 설명하고 약을 추천해 달라고 하면, 존재하지 않는 약물명을 생성하거나, 전혀 적절하지 않은 잘못된 처방을 제시할 가능성도 있습니다. 이로 인해 실제 건강에 위해를 끼칠 수도 있습니다.

법률 영역도 예외는 아닙니다. 실제로 쉼표 하나 차이로 판결이 뒤바뀌는 민감한 세계에서, AI가 존재하지 않는 조항을 인용하거나 잘못된 법률 용어를 사용하는 경우는 큰 문제로 이어질 수 있습니다.

이처럼, 인공지능의 답변이 아무리 자연스럽고 전문가처럼 들리더라도, 그 내용을 곧이곧대로 받아들이는 것은 매우 위험할 수 있습니다. 특히 신뢰가 중요한 분야일수록 AI의 한계를 인지하고, 항상 출처 확인과 교차 검증을 습관화해야 합니다.

📌 왜 인공지능은 존재하지 않는 말을 지어낼까?

AI는 ‘진실’을 아는 존재가 아닙니다.

단지 문장 구조상 가장 자연스러운 말을 예측할 뿐입니다.

인공지능의 답변을 보다 보면, 마치 다 알고 있는 박식한 전문가처럼 느껴질 때가 많습니다. 하지만 그 ‘전문가’가 사실은 말이 되는 문장을 조립하는 기술자에 불과하다면 어떨까요?

AI가 가짜 정보를 만들어내는 이유는 단순한 오류가 아닙니다. 그 작동 원리 자체에서 비롯된 필연적인 현상이기 때문입니다.

주요 원인

- 문장 예측 방식 → 가장 가능성 높은 단어를 예측해서 이어 붙이는 구조

- 학습 데이터의 오류 또는 누락→ 데이터가 부족하거나 부정확한 경우 ‘지어냄’

- 맥락 이해 부족→ A, B, C 사이의 관계를 진짜로 이해하지 못함

- 실시간 정보 반영 불가→ 훈련 시점 이후 정보는 반영되지 않음

1. AI는 ‘정답’을 아는 존재가 아니다

우리가 흔히 사용하는 GPT와 같은 대형언어모델(LLM)은 실제 지식을 기억하고 있는 존재가 아닙니다.

이들은 ‘이 질문 다음에 어떤 문장이 올 가능성이 높을까?’를 예측해서 문장을 만들어냅니다.

즉, AI는 질문의 의미를 ‘이해’해서 답을 내는 것이 아니라, 패턴과 확률에 기반해 가장 적절할 법한 단어를 **“그럴듯하게 조합”**하는 것에 불과합니다.

그래서 실제로는 사실과 다르거나 존재하지 않는 정보라도 문맥상 자연스럽다면 답변으로 내놓을 수 있는 것이죠.

2. 학습 데이터의 불완전성과 편향

AI는 방대한 데이터를 학습하여 만들어지지만, 그 데이터 안에 잘못된 정보나 편향된 내용이 섞여 있다면 어떻게 될까요?

또는 어떤 특정 주제에 대한 정보가 너무 부족하다면?

이 경우 AI는 자신이 아는 범위 내에서 빈틈을 상상력으로 채워 넣듯 만들어냅니다.

특히 게임, 소설, 역사적 인물, 마이너한 콘텐츠에 대해 질문할 때 할루시네이션이 더 자주 발생하는 것도 이런 이유입니다.

3. 맥락을 이해하지 못하는 AI의 한계

현재 대부분의 AI는 ‘맥락’이라는 개념을 완전하게 이해하지 못합니다.

우리가 말을 할 때는 말의 전후 맥락, 감정, 상황, 사회적 코드까지 고려해서 말하지만,

AI는 주어진 문장들의 연결만을 바탕으로 판단합니다.

그래서 A, B, C 사이의 진짜 관계를 파악하는 대신, **‘A 근처에 자주 나오는 단어가 C이니까’**라고 생각하며 말하는 셈이죠.

이것이 지식은 있어 보이지만, 엉뚱한 연결을 해버리는 이유입니다.

4. 실시간 정보 반영 불가

AI는 사전 학습된 데이터를 기반으로 작동하기 때문에, 최신 사건, 뉴스, 법령 개정, 신제품 출시와 같은 실시간 정보를 반영할 수 없습니다.

예를 들어, 2025년에 출시된 제품을 묻는다면 AI는 2023년까지의 정보만 바탕으로 대답하기 때문에 허구의 제품을 말할 수도 있는 것입니다.

결국, AI는 ‘이야기를 만들어내는’ 기술이다

AI는 놀라울 만큼 자연스러운 언어를 생성할 수 있지만, 그 언어가 사실에 기반한 것인지는 따로 확인하지 않습니다.

AI는 말 그대로 "그럴듯한 이야기꾼"이지, "팩트체크 전문가"가 아닌 것입니다.

이러한 구조적 특성을 이해하고 AI를 활용한다면, 잘못된 정보에 휘둘릴 일도 줄어들고, AI의 장점을 안전하게 활용할 수 있습니다.

.

📌 특히 주의가 필요한 분야

분야 이유

| 의료 | 잘못된 처방은 생명에 직결됨 |

| 법률 | 사소한 오류가 판결 결과에 영향 |

| 금융 | 허위 정보로 인한 투자 피해 발생 가능 |

| 교육/논문 | 존재하지 않는 논문, 출처를 제시하는 경우 다수 |

📌어떻게 대응할까?

사용자 입장에서 할 일

- ✔️ 출처 확인 필수

- ✔️ 다른 AI 또는 자료와 교차 검증

- ✔️ 질문을 명확하고 구체적으로 작성

- ✔️ 전문 정보는 AI가 아닌 전문가에게 확인

시스템/사회 대응

- ✅ 출처 기반 응답 시스템 도입

- ✅ 사회적 신뢰 수준에 대한 명확한 고지

- ✅ AI의 응답 권위 남용 방지

- ✅ 교육 현장에서 정보 리터러시 강화

📌 예술가들의 시선

일부 예술가와 사상가들은 AI 할루시네이션을 인간의 꿈에 비유합니다.

기계가 ‘기이한 상상’을 한다는 점에서, 마치 인간이 꿈에서 판타지를 꾸듯 AI도 ‘기계의 꿈’을 꾸는 셈이라는 것이죠.

빌 게이츠 역시 이러한 AI의 반응을 *"기계 환각(machine hallucination)"*이라는 관점에서 언급한 바 있습니다.

하지만 꿈은 꿈이고, 정보는 정보입니다.

정보를 다룰 때는 철저한 검증과 비판적 사고가 반드시 필요합니다.

인공지능이 생성하는 정보는 편리하지만,

그 안에 섞여 있는 할루시네이션은 위험할 수 있습니다.

그럴듯한 말일수록 더 의심하고, 더 검증하는 자세가 필요합니다.

“AI는 진실을 말하지 않는다.

다만 가장 그럴듯한 문장을 말할 뿐이다.”